Kto uczestniczył w konferencji?

The Hack Summit to obowiązkowa konferencja dla każdego związanego z cyberbezpieczeństwem, dlatego nie mogło nas tam zabraknąć! Tematyka była różnorodna: od zagadnień technicznych, poprzez strategię, aż po ryzyko i compliance. Co roku w tym wydarzeniu uczestniczy ponad 2.000 osób z branży. To dwudniowe wydarzenie mające miejsce na PGE Narodowy oferuje uczestnikom możliwość zdobycia najnowszej wiedzy od czołowych ekspertów, a także daje ogromną szansę na nawiązanie cennych kontaktów zawodowych.

Temat naszego wystąpienia: „Stwórzmy sobie p*rno…”

W tym roku na The Hack Summit przygotowaliśmy prezentację o wdzięcznym tytule „Stwórzmy sobie p*rno – czyli co nielegalnego możesz sobie wygenerować wykorzystując AI i jak uniknąć za to kary. Nasze wystąpienie spotkało się z bardzo pozytywnym odzewem ze strony słuchaczy.

Podstawowe pojęcia, które warto znać i o których mówiliśmy podczas naszego wystąpienia to:

- deepfake (oznacza „wygenerowane przez AI lub zmanipulowane przez AI obrazy, treści dźwiękowe lub treści wideo, które przypominają istniejące osoby, przedmioty, miejsca, podmioty lub zdarzenia, które odbiorca mógłby niesłusznie uznać za autentyczne lub prawdziwe”

- deepfake porn

- sextortion jest to pozyskanie od kogoś materiałów o charakterze seksualnym, a następnie wymuszanie na nim pieniędzy lub kolejnych treści pod groźbą opublikowania otrzymanych wcześniej zdjęć lub filmów.

- CG- Csam (skrót oznacza Child Sexual Abuse Materials – materiały przedstawiające seksualne wykorzystanie dziecka.

Wracając do tematu naszego wystąpienia dostępne na rynku narzędzia AI świetnie radzą sobie z wytwarzaniem materiałów CSAM. Jest to niebezpieczne i niesie za soba wiele zagrożeń.

Dodatkowo pokazaliśmy, że w sieci istnieją aplikacje, które za dodatkową opłatą mogą „rozebrać” człowieka, co pokazaliśmy na kilku slajdach.

Obecnie szacuje się [dane Thorn] że mniej niż 1% udostępnianych przez społeczność plików CSAM to foto realistyczne pliki CG-CSAM. Z tych treści ok 66% to wysoko realistyczne, trudne do rozróżnienia obrazy. Przy obecnym postępie AI za rok będą one nie do odróżnienia. Czyż to nie jest przerażające?

Jak możemy rozpoznać Deepfake?

Deepfake to współczesne ogromne zagrożenie, które wraz z rozwojem technologii może być coraz trudniej wykrywalne w sieci. W rozpoznaniu takich materiałów zwykle wystarczy dokładnie patrzeć i słuchać.

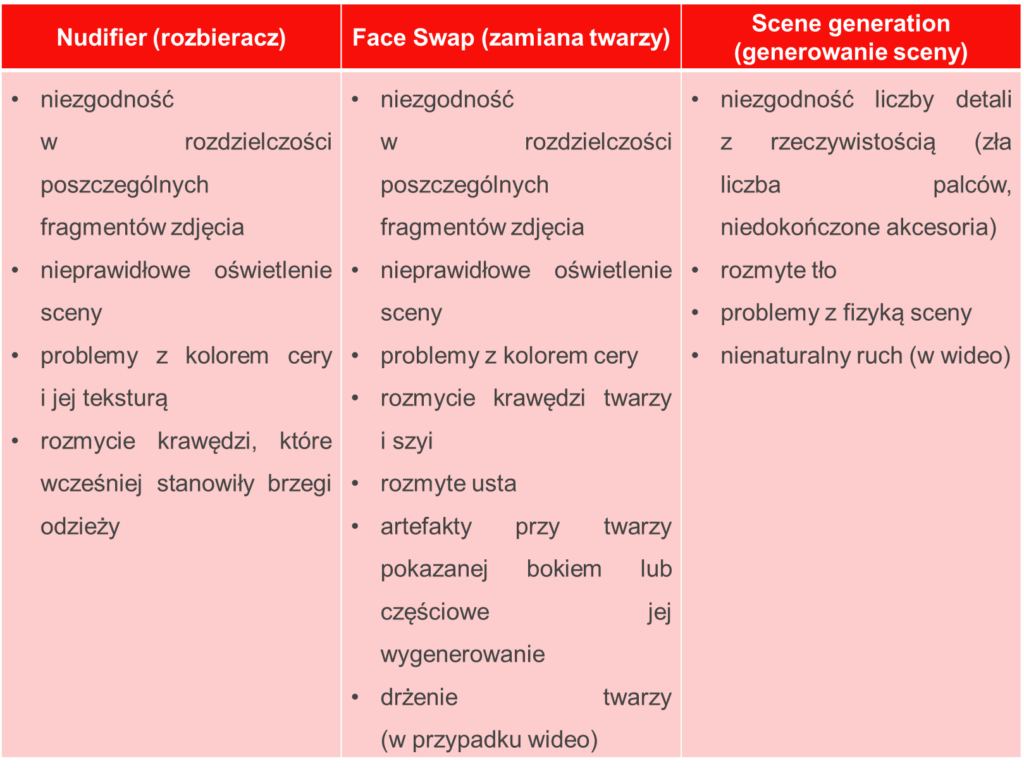

Poniżej w tabeli zebraliśmy kilka ważnych wskazówek, jak rozpoznać deepfake:

Art.202 – z czym to się je?

Amanda Krać-Batyra – biegły sądowy przy Sądzie Okręgowym w Lublinie z zakresu antropologii sądowej, antroposkopii i antropometrii (II kadencja od 2024 do 2029) ma do czynienia na co dzień w swojej pracy ze sprawami związanymi z tym właśnie artykułem. Przypomnijmy sobie zatem treści jego kilku ustępów:

Art. 202. Kodeksu karnego Publiczna prezentacja lub produkcja, rozpowszechnianie, przechowywanie i posiadanie treści pornograficznych

§ 4. Kto utrwala treści pornograficzne z udziałem małoletniego, podlega karze pozbawienia wolności od roku do lat 10.

§ 4a. Kto przechowuje, posiada lub uzyskuje dostęp do treści pornograficznych z udziałem małoletniego, podlega karze pozbawienia wolności od 3 miesięcy do lat 5.

§ 4b. Kto produkuje, rozpowszechnia, prezentuje, przechowuje lub posiada treści p*rnograficzne przedstawiające wytworzony albo przetworzony wizerunek małoletniego uczestniczącego w czynności s*ksualnej podlega grzywnie, karze ograniczenia wolności albo pozbawienia wolności do lat 2.

Dlaczego właściwie o tym piszemy? Nasza praca to nie tylko pisanie opinii dla sądów czy prokuratur. Często spotykamy się na salach sądowych i tam dostajemy pytania w stylu:

•czy istnieje technologia, która może generować fotorealistyczne zdjęcia p*rnograficzne?

•czy generatory zdjęć generują (wytwarzają) zdjęcia?

•czy jest 100% pewna metoda odróżnienia zdjęcia zamieszczonego w Internecie przedstawiającego rzeczywistą sytuację, a zdjęcia wygenerowanego (wytworzonego) przez AI

Jak się zapewne domyślacie odpowiedzi są proste i każdy może na te pytania odpowiedzieć, jednak najgorsza w tym jest linia obrońcy: zdjęcia, które posiadał mój klient zostały wytworzone przez AI.

Jeśli oskarżony w swoich zbiorach posiada zdjęcia nagich dzieci bez czynności s*ksualnych, wystarczy przyjąć linie obrony, że obraz wytworzyła AI, a co a tym idzie jest to trudne do odróżnienia od zdjęcia realnego dziecka.

Wnioski po konferencji

Przeszukaliśmy dużą część Internetu nie tylko po to, by znaleźć strony do generowania p*rno, ale także po to, by zweryfikować, czy można tam wygenerować wizerunek dziecka… Smutny wniosek jest taki, że niestety da się, co daje ogromną przestrzeń do działań dla cyberprzestępców.